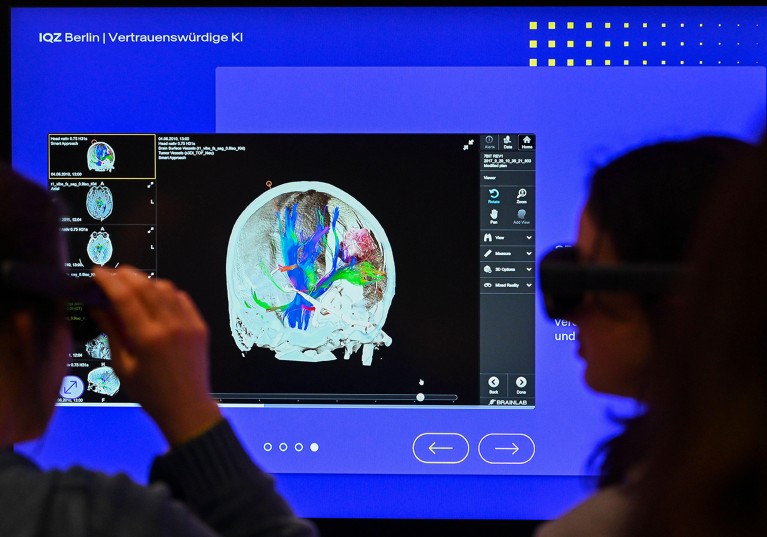

I visitatori di una mostra interattiva di intelligenza artificiale presso il Museo della Tecnologia tedesco a Berlino usano gli occhiali da realizzazione virtuale per visualizzare un’immagine del cervello.Credito: Jens Kalaene/DPA/Alamy

A seguito di un’ondata di eccitazione dopo il lancio del chatbot Chatgpt di Intelligence Artificiale (AI) nel novembre 2022, i governi in tutto il mondo si sono impegnati a creare politiche che promuoveranno lo sviluppo dell’IA, garantendo al contempo che la tecnologia rimane sicura e affidabile. A febbraio, sono entrate in vigore diverse disposizioni della legge sull’intelligenza artificiale dell’Unione europea – la prima regolamentazione completa dell’IA al mondo – vietando lo spiegamento di alcune applicazioni, come i sistemi automatizzati che affermano di prevedere il crimine o inferire le emozioni dalle caratteristiche facciali.

La maggior parte dei sistemi di intelligenza artificiale non dovrà affrontare un divieto assoluto, ma sarà invece regolato usando una scala basata sul rischio, da alto a basso. Sono attesi dibattiti feroci sulla classificazione della legge dei sistemi “ad alto rischio”, che avranno la più severa supervisione. Una guida più chiara dell’UE inizierà a emergere in agosto, ma è probabile che molte soluzioni cliniche basate sull’intelligenza artificissano a causa del potenziale danno associato a previsioni distorte o difettose in un contesto medico.

Come sfruttare il potenziale di AI nella ricerca – responsabilmente ed eticamente

L’intelligenza artificiale clinica-se implementata con cautela-potrebbe migliorare l’accesso e i risultati sanitari razionalizzando i processi di gestione ospedaliera (come la pianificazione dei pazienti e la presa dei medici), a supporto della diagnostica (come l’identificazione di anomalie nei raggi X) e adattando i piani di trattamento per i singoli pazienti. Ma questi benefici comportano rischi-ad esempio, le decisioni di un sistema guidato dall’IA non possono sempre essere facilmente spiegate, limitando la portata della supervisione umana in tempo reale.

Ciò è importante, perché tale supervisione è esplicitamente obbligatoria ai sensi della legge. I sistemi ad alto rischio devono essere trasparenti e progettati in modo che un sorvegliante possa comprendere i loro limiti e decidere quando dovrebbero essere utilizzati (vedi go.nature.com/3dtgh4x).

Per impostazione predefinita, la conformità verrà valutata utilizzando una serie di standard AI armonizzati, ma questi sono ancora in fase di sviluppo. (Il rispetto di questi standard non sarà obbligatorio, ma dovrebbe essere il modo preferito per la maggior parte delle organizzazioni di dimostrare la conformità.) Tuttavia, finora, ci sono pochi modi tecnologici stabiliti per soddisfare questi prossimi requisiti legali.

Qui, proponiamo che nuovi approcci allo sviluppo dell’IA – basati sulle pratiche standard dei team medici multidisciplinari, che comunicano attraverso i confini disciplinari usando concetti ampi e condivisi – possano supportare la supervisione. Questa dinamica offre un utile progetto per la prossima generazione di sistemi di intelligenza artificiale focalizzati sulla salute che sono affidabili dagli operatori sanitari e soddisfano le aspettative normative dell’UE.

Collaborando con AI

Le decisioni cliniche, in particolare quelle relative alla gestione delle persone con condizioni complesse, in genere tengono conto di varie fonti di informazione: dalle cartelle cliniche elettroniche e dai fattori dello stile di vita agli esami del sangue, alle scansioni di radiologia e ai risultati della patologia. La formazione clinica, al contrario, è altamente specializzata e poche persone possono interpretare accuratamente più tipi di dati medici specialistici (come sia la radiologia che la patologia). Il trattamento di individui con condizioni complesse, come il cancro, è quindi in genere gestito attraverso riunioni multidisciplinari del team (noto come consigli di tumore negli Stati Uniti) in cui sono rappresentati tutti i campi clinici pertinenti.

L’IA può scuotere la ricerca traslazionale?

Poiché coinvolgono clinici di diverse specialità, le riunioni multidisciplinari del team non si concentrano sulle caratteristiche grezze di ciascun tipo di dati, poiché questa conoscenza non è condivisa dal team completo. Invece, i membri del team comunicano con riferimento a “concetti” intermedi, che sono ampiamente compresi. Ad esempio, quando giustifica un percorso di trattamento proposto per un tumore, è probabile che i membri del team si riferiscano ad aspetti della malattia, come il sito del tumore, lo stadio del cancro o il grado e la presenza di modelli specifici di marcatori molecolari. Discuteranno anche delle caratteristiche associate al paziente, tra cui l’età, la presenza di altre malattie o condizioni, indice di massa corporea e fragilità.

Questi concetti, che rappresentano riassunti interpretabili e di alto livello dei dati grezzi, sono i mattoni del ragionamento umano: il linguaggio del dibattito clinico. In genere sono inoltre caratteristiche nelle linee guida cliniche nazionali per la selezione dei trattamenti per i pazienti.

In particolare, questo processo di dibattito utilizzando il linguaggio dei concetti condivisi è progettato per facilitare la trasparenza e la supervisione collettiva in un modo che parallela alle intenzioni della legge UE AI. Affinché l’intelligenza artificiale clinica sia conforme alla legge e acquisire la fiducia dei medici, riteniamo che dovrebbe rispecchiare questi processi decisionali clinici stabiliti. L’intelligenza artificiale clinica-proprio come i medici in team multidisciplinari-dovrebbe utilizzare concetti ben definiti per giustificare le previsioni, invece di indicare semplicemente la loro probabilità.

Crisi di spiegabilità

Esistono due approcci tipici per l’IA spiegabile1 -Un sistema che spiega il suo processo decisionale. Uno comporta la progettazione del modello in modo che abbia regole integrate, garantendo la trasparenza dall’inizio. Ad esempio, uno strumento per rilevare la polmonite dai raggi X del torace potrebbe valutare l’opacità polmonare, assegnare un punteggio di gravità e classificare il caso sulla base di soglie predefinite, chiarire il suo ragionamento ai medici. Il secondo approccio prevede l’analisi della decisione del modello dopo che è stata presa (“post hoc”). Questo può essere fatto attraverso tecniche come la mappatura della salienza, che evidenzia le regioni dei raggi X che hanno influenzato la previsione del modello.

Tuttavia, entrambi gli approcci hanno gravi limitazioni2. Per capire perché, considera uno strumento di intelligenza artificiale che è stato addestrato per aiutare i dermatologi a decidere se una talpa sulla pelle è benigna o maligna. Per ogni nuovo paziente, un approccio di spiegabilità post-hoc potrebbe evidenziare i pixel nell’immagine della talpa che erano più importanti per la previsione del modello. Ciò può identificare il ragionamento ovviamente errato, ad esempio, evidenziando i pixel nell’immagine che non sono correlati alla talpa (come marchi di penna o altre annotazioni da parte di medici)3.

Il Parlamento europeo a Bruxelles ha adottato l’Artificial Intelligence Act lo scorso marzo.Credito: Geert Vanden Wijngaert/AP Photo/Alamy

Quando la talpa è evidenziata, tuttavia, potrebbe essere difficile2,4 Per un clinico di supervisione – anche di grande esperienza – sapere se l’insieme di pixel evidenziati è clinicamente significativo o semplicemente spurosamente associato alla diagnosi. In questo caso, l’uso dello strumento AI potrebbe effettuare un onere cognitivo extra sul medico.

Un design basato sulle regole, tuttavia, limita l’apprendimento di un modello di intelligenza artificiale per conformarsi rigidamente a principi noti o meccanismi causali. Tuttavia, i compiti per i quali è più probabile che l’IA sia clinicamente utile non sono sempre conformi ai semplici processi decisionali o potrebbero comportare meccanismi causali che si combinano in modi intrinsecamente complessi o controintuitivi. Tali modelli basati sulle regole non funzionano bene in precisione nei casi in cui un medico potrebbe aver bisogno di maggiore assistenza.

Contrariamente a questi approcci, quando un dermatologo spiega la loro diagnosi a un collega o un paziente, tendono a non parlare di pixel o strutture causali. Invece, fanno uso di concetti di alto livello facilmente compresi, come l’asimmetria della mole, l’irregolarità del bordo e il colore, per supportare la loro diagnosi. I medici che utilizzano strumenti di intelligenza artificiale che presentano concetti di alto livello hanno riportato una maggiore fiducia nelle raccomandazioni degli strumenti5.

Negli ultimi anni sono stati sviluppati approcci alla spiegazione di intelligenza artificiale che potrebbe codificare tale ragionamento concettuale e aiutare a supportare le decisioni del gruppo. I modelli di collo di bottiglia (CBM) sono un esempio promettente6. Questi sono addestrati non solo per imparare i risultati di interesse (come la prognosi o il corso di trattamento), ma anche per includere importanti concetti intermedi (come lo stadio del tumore o il grado) che sono significativi per i sorveglianti umani. Questi modelli possono quindi fornire sia una previsione complessiva che una serie di concetti comprensibili, appresi dai dati, che giustificano le raccomandazioni del modello e il dibattito di supporto tra i decisori.

Aiuto per la pianificazione del trattamento del cancro

Questo tipo di intelligenza artificiale spiegabile potrebbe essere particolarmente utile quando si affrontano problemi complessi che richiedono armonizzazione di tipi di dati distinti. Inoltre, sono adatti alla conformità normativa ai sensi della legge UE AI, perché forniscono trasparenza in un modo specificamente progettato per facilitare la supervisione umana. Ad esempio, se un CBM assegna erroneamente un concetto clinico importante a un determinato paziente (come la previsione di uno stadio tumorale errato), allora il team clinico di supervisione non sa immediatamente di non fare affidamento sulla previsione dell’IA.

Inoltre, a causa di come i CBM sono addestrati, tali errori a livello di concetto possono anche essere immediatamente corretti dal team clinico, consentendo al modello di “ricevere aiuto”7 e rivedere la sua previsione e giustificazione complessive con l’aiuto dell’input clinico. In effetti, i CBM possono essere addestrati per aspettarsi tali interventi umani e usarli per migliorare le prestazioni del modello nel tempo.