Uno dei privilegi di essere nel campus del Massachusetts Institute of Technology (MIT) a Cambridge è vedere scorci del futuro, dai progressi del calcolo quantistico e della sostenibilità energetica e della produzione, alla progettazione di nuovi antibiotici. Capisco tutto profondamente? No, ma sono in grado di avvolgere la testa su gran parte quando mi viene chiesto di creare un’immagine per documentare la ricerca.

La gioia di essere un fotografo di scienze è che devo conoscere le cose che sto documentando per produrre immagini comunicative e affidabili, intese come una forma di dati, per i ricercatori che mi danno il benvenuto nei loro laboratori.

Ma ora, con l’ampia disponibilità di strumenti di intelligenza artificiale generativa (GENAI), devono essere poste molte domande. Ci sarà un punto in cui, con solo pochi tasti e suggerimenti, uno scienziato può creare un “visivo” della loro ricerca, come faccio con la mia macchina fotografica e considerare quell’immagine un record del lavoro? Ricercatori, riviste e lettori saranno in grado di individuare immagini create artificialmente e capire che non documentano veramente il lavoro? E infine, da un punto di vista personale, ci sarà ancora un posto per un fotografo di scienze come me per far avanzare la comunicazione della ricerca? Ecco cosa ho scoperto durante la sperimentazione di generatori di immagini di intelligenza artificiale (AI).

Realtà e rappresentazione

Innanzitutto, ricordiamoci delle differenze tra una fotografia, in cui ogni pixel corrisponde ai fotoni del mondo reale e a un visivo Genai, creato con un modello di diffusione-un complesso processo computazionale che genera qualcosa che sembra reale ma che non potrebbe mai esistere.

Per esplorare queste differenze, ho deciso di sperimentare i modelli di diffusione Dall-E di Openii e Open di Midjourney e Openjourney per riprodurre il lavoro mostrato in una delle mie fotografie scientifiche più popolari-con l’aiuto del ricercatore scientifico-visiva , Massachusetts.

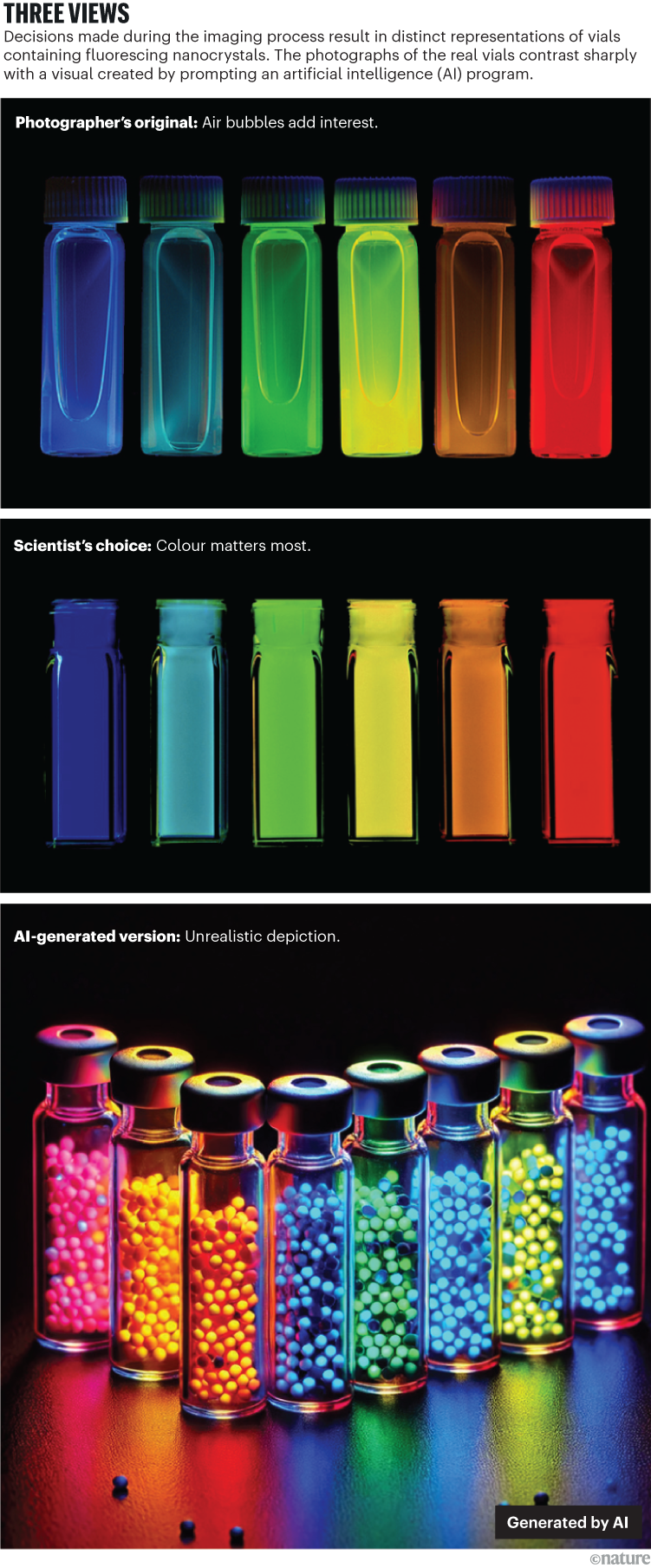

Nel 1997, Moungi Bawendi, un chimico del MIT, mi ha chiesto di fare una foto dei suoi nanocristalli (punti quantici). Quando sono eccitati con luce ultravioletta, questi cristalli fluoro a lunghezze d’onda diverse a seconda delle loro dimensioni. Bawendi, che in seguito ha condiviso un premio Nobel per questo lavoro, non è piaciuta la prima immagine (vedi “tre visualizzazioni”), in cui avevo messo le fiale piatte in panchina di laboratorio, scattando una fotografia dall’alto verso il basso. Puoi dire che era così che li avevo messi, perché puoi vedere le bolle d’aria nei tubi. Era intenzionale; Ho pensato che avesse reso l’immagine più interessante.

Credito: Felice Frankel

La seconda iterazione è stata utilizzata sulla copertina del novembre 1997 del Journal of Physical Chemistry B (Vedi “tre visualizzazioni”). Quella fotografia fornisce un record semplice della ricerca ed evidenzia l’importanza di collaborare con lo scienziato, una parte essenziale del mio processo.

Per generare un’immagine comparabile in Dall-E, ho usato il prompt “Crea una foto dei nanocristalli di Moungi Bawendi in fiale su uno sfondo nero, fluorescente a diverse lunghezze d’onda, a seconda della loro dimensione, quando eccitato con la luce UV”.

La Cina ha fatto le onde con DeepSeek, ma la sua vera ambizione è l’innovazione industriale guidata dall’IA

Le persone potrebbero pensare che l’immagine prodotta dal programma sia attraente (vedi “tre visualizzazioni”), ma non è nemmeno vicina alla realtà catturata nella fotografia originale. Dall-E ha introdotto punti simili a talloni che non erano nel prompt. L’algoritmo presumibilmente ha trovato le parole “punti quantici” nel set di dati del modello AI che lo sta alla base e ha usato tali informazioni per sostituire le parole “nanocristalli”.

Più preoccupante è il fatto che, in ogni fiala, ci sono punti con colori diversi, il che implica che i campioni contengono un mix di materiali che fluoro a una vasta gamma di lunghezze d’onda – questo è inaccurato. Inoltre, alcuni dei punti sono mostrati sdraiati sulla superficie del tavolo. È stata una decisione estetica presa dal modello? Trovo l’affascinante visivo risultante (vedi informazioni supplementari).

I risultati della mia sperimentazione di intelligenza artificiale sono spesso immagini simili a cartone animato che difficilmente possono passare come realtà-per non parlare della documentazione-ma ci sarà un tempo in cui lo saranno. Nelle conversazioni con i colleghi nelle comunità di ricerca e scienza informatica, sono tutti d’accordo sul fatto che dovremmo avere standard chiari su ciò che è e non è consentito. Secondo me, una visualizzazione di Genai non dovrebbe mai essere consentita come documentazione.

Manipolato contro AI generato

L’avvento dell’IA significa che dobbiamo chiarire tre questioni fondamentali relative alla comunicazione visiva: la differenza tra illustrazione e documentazione, etica della manipolazione delle immagini e la necessità disperata per la formazione di comunicazione visiva per scienziati e ingegneri.

Le decisioni su come inquadrare un’immagine – cosa includere o lasciare fuori – sono già una manipolazione della realtà. Gli strumenti che le persone decidono di utilizzare fanno anche parte della manipolazione. Ogni fotocamera digitale crea una fotografia distinta. L’algoritmo di un iPhone Apple migliora i colori dell’immagine in modo diverso a quello di un telefono Samsung. Allo stesso modo, le immagini del vicino infrarosso prodotte dal telescopio spaziale di James Webb sono progettate per essere diverse, ma complemento, le scansioni ottiche del telescopio spaziale Hubble.

Come AI sta sbloccando testi antichi e potrebbe riscrivere la storia

Prendendo il punto ancora oltre, i colori che vediamo in tutte quelle incredibili immagini dell’universo sono migliorati digitalmente e ci danno ancora più interpretazioni della realtà. Visto attraverso questo obiettivo, è chiaro che gli umani sono stati, in effetti, generando artificialmente immagini da anni, senza necessariamente etichettarle come tali. Tuttavia, esiste una differenza cruciale tra migliorare una fotografia con software per rappresentare la realtà e creare una realtà da set di dati addestrati.

Come fotografo di scienze, sono profondamente consapevole della differenza tra un’illustrazione e una fotografia documentaria, ma sono meno fiducioso che i programmi di intelligenza artificiale possano fare questa distinzione. Un’illustrazione o diagramma è una rappresentazione di qualcosa, che traduce e descrive visivamente un concetto o una struttura usando notazioni, colori, forme e così via. Una fotografia ottica documentaria o una realizzata con la microscopia elettronica a scansione o trasmissione, viene creata con fotoni ed elettroni ed è quindi una rappresentazione di un oggetto, anche se non è l’oggetto stesso. La differenza tra i due è nell’intento.

Con illustrazione, l’intento è descrivere e chiarire il lavoro. La grafica di Genai probabilmente eccellerà in quell’attività. Ma per una fotografia documentaria, l’intento è di avvicinarci il più vicino possibile alla realtà. Entrambi sono, in sostanza, già una forma di manipolazione o un atto di generazione artificiale, e qui sta l’importanza di definire e discutere la loro etica prima di includere gli strumenti Genai.

Gli editori ora dispongono di software per identificare varie manipolazioni nelle immagini già esistenti (vedi Natura 626697–698; 2024), ma, francamente, i programmi di intelligenza artificiale saranno alla fine in grado di aggirare questi saluti. Ci sono sforzi per trovare il modo di tracciare la provenienza di una fotografia o per documentare qualsiasi manipolazione dell’originale. Ad esempio, la comunità fotografica forense, attraverso la coalizione globale per la provenienza dei contenuti e l’autenticità, fornisce informazioni tecniche ai produttori di telecamere in merito alla capacità di tracciare la provenienza di una fotografia tenendo un registro nella telecamera di qualsiasi manipolazione. Come si può immaginare, non tutti i produttori sono a bordo.

Internet e l’intelligenza artificiale stanno influenzando la nostra memoria? Cosa dice la scienza

La comunità scientifica ha ancora il tempo di creare un sistema di trasparenza e formare linee guida per quanto riguarda le immagini generate dall’IA. Come minimo, ogni visivo di Genai dovrebbe essere chiaramente etichettato come tale e il processo e gli strumenti utilizzati per crearla dovrebbero essere chiaramente dichiarati e includere, ove possibile, il credito per tutte le immagini di origine fornite al motore AI. Tuttavia, elencare le fonti rappresenta una sfida.

Due articoli hanno sollevato un problema importante evidenziando potenziali violazioni della privacy e del copyright quando si utilizzano i modelli di diffusione (N. Carini et al. Preprint su arxiv https://doi.org/grqmsb (2023); e vedi go.nature.com/4jqyevn). Il credito è fattibile solo in un sistema chiuso (che i modelli di diffusione non sono) per il quale i dati di addestramento sono noti e completamente documentati. Ad esempio, Springer Nature, che pubblica Natura (Natura è indipendente dal suo editore), ha recentemente incluso un’eccezione nella sua politica per il programma Alphafold di Google DeepMind per coprire questo tipo di utilizzo (per i modelli addestrati su una serie specifica di dati scientifici). Tuttavia, le persone dovrebbero tenere presente che Alphafold non è uno strumento Genai che crea immagini: genera modelli strutturali (dati di coordinate) che vengono quindi trasformati in immagini dalle persone (non da strumenti Genai).

Fortunatamente, gli sforzi stanno affrontando problemi di privacy. I creatori possono ora usare una sorta di metadati “evidenti” chiamati credenziali di contenuto, come spiega Adobe nel suo manuale, “Ottieni un adeguato riconoscimento e promuove la trasparenza nel processo di creazione dei contenuti” (vedi go.nature.com/3wx92ng).

Standard etici

Per anni ho suggerito che gli scienziati devono essere formati nell’etica della comunicazione visiva e la facile disponibilità del software di creazione di immagini AI aggiunge urgenza a questa discussione.

Ad esempio, ricordo un’esperienza con un ingegnere che ha modificato una fotografia che avevo fatto delle loro ricerche e volevo pubblicarla, insieme all’articolo presentato (vedi informazioni supplementari). Il ricercatore non ha considerato che alterare l’immagine fosse, in effetti, simile al cambiamento dei loro dati perché non gli era stato insegnato l’etica di base della manipolazione dell’immagine e della comunicazione visiva.