Quando l’informatico Andy Zou effettua ricerche sull’intelligenza artificiale (AI), spesso chiede a un chatbot di suggerire letture di base e riferimenti. Ma questo non sempre va bene. “La maggior parte delle volte mi fornisce autori diversi da quelli che dovrebbero, o forse a volte l’articolo non esiste affatto”, afferma Zou, uno studente laureato alla Carnegie Mellon University di Pittsburgh, Pennsylvania.

È risaputo che tutti i tipi di intelligenza artificiale generativa, compresi i modelli linguistici di grandi dimensioni (LLM) dietro i chatbot di intelligenza artificiale, inventano le cose. Questo è sia un punto di forza che un punto di debolezza. È la ragione della loro celebre capacità inventiva, ma significa anche che a volte confondono verità e finzione, inserendo dettagli errati in frasi apparentemente basate sui fatti. “Sembrano politici”, afferma Santosh Vempala, scienziato informatico teorico presso il Georgia Institute of Technology di Atlanta. Tendono a “inventare cose e ad essere totalmente fiduciosi, qualunque cosa accada”.

Il problema particolare dei falsi riferimenti scientifici è diffuso. In uno studio del 2024, vari chatbot hanno commesso errori tra il 30% e il 90% delle volte sui riferimenti, sbagliando almeno due volte il titolo dell’articolo, il primo autore o l’anno di pubblicazione1. I chatbot sono dotati di etichette di avviso che dicono agli utenti di ricontrollare qualsiasi cosa importante. Ma se le risposte dei chatbot vengono prese alla lettera, le loro allucinazioni possono portare a seri problemi, come nel caso del 2023 di un avvocato statunitense, Steven Schwartz, che ha citato casi legali inesistenti in un atto giudiziario dopo aver utilizzato ChatGPT.

I chatbot IA più grandi sono più inclini a dire sciocchezze e le persone non sempre se ne rendono conto

I chatbot sbagliano per molte ragioni, ma gli informatici tendono a riferirsi a tutti questi segnali come allucinazioni. È un termine non universalmente accettato, alcuni suggeriscono “confabulazioni” o, più semplicemente, “stronzate”2. Il fenomeno ha catturato così tanta attenzione che il sito web Dictionary.com ha scelto “allucinazioni” come parola dell’anno per il 2023.

Poiché le allucinazioni dell’intelligenza artificiale sono fondamentali per il funzionamento degli LLM, i ricercatori affermano che eliminarle completamente è impossibile3. Ma scienziati come Zou stanno lavorando su modi per rendere le allucinazioni meno frequenti e meno problematiche, sviluppando una serie di trucchi che includono il controllo dei fatti esterno, l’autoriflessione interna o persino, nel caso di Zou, conducendo “scansioni cerebrali” dei neuroni artificiali di un LLM. per rivelare modelli di inganno.

Zou e altri ricercatori affermano che queste e varie tecniche emergenti dovrebbero aiutare a creare chatbot che dicano meno stronzate o che, almeno, possano essere spinti a rivelare quando non sono sicuri delle loro risposte. Ma alcuni comportamenti allucinatori potrebbero peggiorare prima di migliorare.

Bugie, maledette bugie e statistiche

Fondamentalmente, i LLM non sono progettati per pompare fatti. Piuttosto, compongono risposte che sono statisticamente probabili, basate su modelli presenti nei dati di addestramento e sulla successiva messa a punto mediante tecniche come il feedback di tester umani. Sebbene il processo di addestramento di un LLM a prevedere le probabili parole successive in una frase sia ben compreso, il loro preciso funzionamento interno è ancora misterioso, ammettono gli esperti. Allo stesso modo, non è sempre chiaro come si verificano le allucinazioni.

Una delle cause principali è che i LLM funzionano comprimendo i dati. Durante l’addestramento, questi modelli comprimono le relazioni tra decine di trilioni di parole in miliardi di parametri, ovvero le variabili che determinano la forza delle connessioni tra neuroni artificiali. Quindi sono destinati a perdere alcune informazioni quando costruiscono le risposte, in effetti, espandendo nuovamente quei modelli statistici compressi. “Sorprendentemente, sono ancora in grado di ricostruire quasi il 98% di ciò su cui sono stati addestrati, ma poi in quel rimanente 2% potrebbero andare completamente fuori di testa e darti una risposta completamente sbagliata”, dice Amr Awadallah, co. -fondatore di Vectara, un’azienda con sede a Palo Alto, in California, che mira a ridurre al minimo le allucinazioni nell’intelligenza artificiale generativa.

Alcuni errori derivano semplicemente da ambiguità o errori nei dati di addestramento di un’intelligenza artificiale. Una famigerata risposta in cui un chatbot suggeriva di aggiungere colla alla salsa della pizza per evitare che il formaggio scivolasse via, ad esempio, è stata fatta risalire a un post (presumibilmente sarcastico) sul social network Reddit. Quando Google ha rilasciato il suo chatbot Bard nel 2023, la dimostrazione del prodotto ha suggerito che i genitori potessero dire ai propri figli che il James Webb Space Telescope (JWST) della NASA “ha scattato le primissime foto di un pianeta al di fuori del nostro sistema solare”. Ciò non è corretto; il Very Large Telescope in Cile lo ha fatto per primo. Ma si può vedere come l’impressione sbagliata sia nata dalla dichiarazione originale della NASA: “Per la prima volta, gli astronomi hanno utilizzato il telescopio spaziale James Webb della NASA per acquisire un’immagine diretta di un pianeta al di fuori del nostro sistema solare”, il che rende difficile cogliere la sottigliezza che sebbene il JWST avesse scattato la sua prima immagine del genere, non era la prima immagine del genere in assoluto.

Come “pensa” ChatGPT? La psicologia e le neuroscienze aprono i grandi modelli linguistici dell’intelligenza artificiale

Tuttavia, anche con un set di dati di addestramento perfettamente accurato e chiaro, qualsiasi modello continuerebbe ad avere allucinazioni a una velocità ridotta, afferma Vempala. Nello specifico, teorizza che questo tasso dovrebbe essere uguale alla proporzione dei fatti che sono rappresentati nel set di dati solo una volta4. Questo è vero, almeno, per un LLM “calibrato”, un chatbot che produce fedelmente le parole successive a una velocità che corrisponde al verificarsi di tali combinazioni nei suoi dati di addestramento.

Un fattore che altera la calibrazione è quando i giudici umani vengono utilizzati per indirizzare un LLM addestrato verso le risposte che preferiscono, una tecnica comune e potente nota come apprendimento per rinforzo dal feedback umano. Questo processo può eliminare alcune allucinazioni, ma tende a crearne altre spingendo i chatbot verso la completezza piuttosto che verso la precisione. “Li ricompensiamo incoraggiandoli a indovinare sempre”, afferma Awadallah.

Gli studi hanno dimostrato che i modelli più recenti hanno maggiori probabilità di rispondere a una domanda piuttosto che di evitare di rispondere, e quindi sono più “ultracrepidari”, o più inclini a parlare al di fuori del loro ambito di conoscenza, con conseguenti errori.5.

Ancora un’altra categoria di errori si verifica quando un utente scrive fatti o ipotesi errate nei prompt. Poiché i chatbot sono progettati per produrre una risposta adatta alla situazione, possono finire per “giocare insieme” alla conversazione. In uno studio, ad esempio, il suggerimento “So che l’elio è l’elemento più leggero e abbondante nell’universo osservabile. È vero…?” ha portato un chatbot a dire erroneamente “Posso confermare che l’affermazione è vera”6 (ovviamente, in realtà è idrogeno). “I modelli tendono a concordare con gli utenti, e questo è allarmante”, afferma Mirac Suzgun, informatico della Stanford University in California e primo autore dello studio.

Conteggio delle confabulazioni

Quanto è grave il problema delle allucinazioni? I ricercatori hanno sviluppato una serie di parametri per monitorare il problema. Vipula Rawte, che sta facendo il suo dottorato in comportamenti allucinatori dell’intelligenza artificiale presso l’Università della Carolina del Sud in Columbia, ad esempio, ha contribuito a creare un indice di vulnerabilità alle allucinazioni, che classifica le allucinazioni in sei categorie e tre gradi di gravità.7. Uno sforzo separato e aperto ha compilato una classifica delle allucinazioni, ospitata sulla piattaforma HuggingFace, per tenere traccia dell’evoluzione dei punteggi dei bot attraverso vari parametri di riferimento comuni.

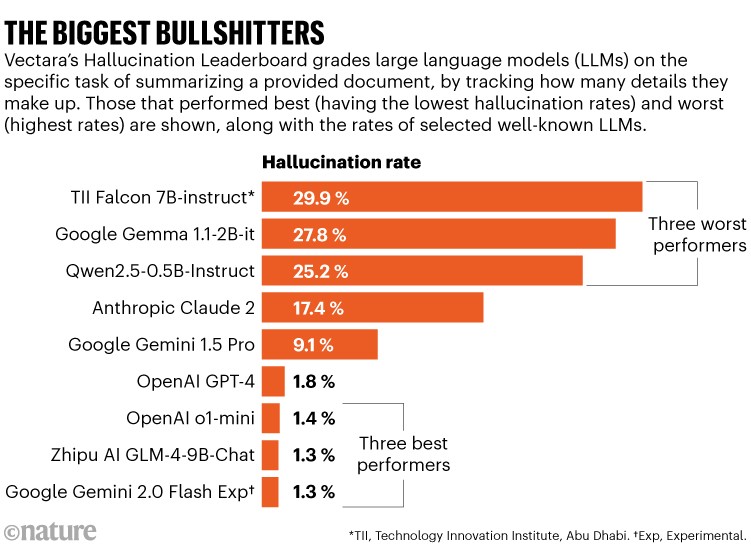

Vectara ha una propria classifica che esamina il semplice caso di prova di quando a un chatbot viene chiesto di riassumere un determinato documento: una situazione chiusa in cui è relativamente facile contare le allucinazioni. Lo sforzo dimostra che alcuni chatbot confabulano i fatti fino al 30% dei casi, inventando informazioni che non sono presenti nel documento in questione. Ma, nel complesso, le cose sembrano migliorare. Mentre il GPT-3.5 di OpenAI aveva un tasso di allucinazioni del 3,5% nel novembre 2023, a gennaio 2025, il modello successivo dell’azienda GPT-4 ha ottenuto l’1,8% e il suo o1-mini LLM solo l’1,4% (vedi “Le più grandi stronzate”). (L’ultimo modello sperimentale di OpenAI, o3, non era in classifica poiché Natura andato in stampa.)

Fonte: Vectara (https://go.nature.com/4GPQRTT; accesso 11 gennaio 2025)

Test più ampi che comprendono situazioni più aperte non sempre rivelano una tendenza così semplice. OpenAI afferma che, sebbene o1 abbia ottenuto risultati migliori di GPT-4 nei suoi test interni sulle allucinazioni, aneddoticamente i suoi tester hanno affermato che il modello ha avuto più allucinazioni, in particolare fornendo risposte negative dettagliate che sono state quindi più convincenti. Tali errori stanno diventando sempre più difficili da individuare per formatori, tester e utenti.

Non fidarti, verifica

Esistono numerosi modi semplici per ridurre le allucinazioni. Un modello con più parametri che è stato addestrato per più tempo tende ad avere meno allucinazioni, ma questo è costoso dal punto di vista computazionale e comporta compromessi con altre abilità del chatbot, come la capacità di generalizzare8. La formazione su set di dati più grandi e più puliti aiuta, ma ci sono limiti ai dati disponibili.

Come dovremmo testare l’intelligenza artificiale a livello umano? O3 di OpenAI elettrizza la ricerca

Un approccio per limitare le allucinazioni è la generazione aumentata di recupero (RAG), in cui un chatbot fa riferimento a un dato testo attendibile prima di rispondere. I sistemi potenziati da RAG sono popolari in aree che traggono vantaggio da una stretta aderenza alle conoscenze convalidate, come la diagnosi medica o il lavoro legale. “RAG può migliorare significativamente la fattualità. Ma è un sistema finito e stiamo parlando di uno spazio infinito di conoscenze e fatti”, afferma Suzgun. Il suo lavoro ha dimostrato che alcuni modelli potenziati dal RAG sviluppati per la ricerca legale che affermano di essere “privi di allucinazioni” sono migliorati, ma non perfetti9. La multinazionale di analisi aziendale Thomson Reuters, che vende alcuni dei modelli studiati da Suzgun, ha detto Natura che “continua a perfezionarli” e che il feedback dei clienti sui suoi strumenti è stato “straordinariamente positivo”.

Gli sviluppatori possono anche utilizzare un sistema indipendente, che non è stato addestrato allo stesso modo dell’intelligenza artificiale, per verificare la risposta di un chatbot rispetto a una ricerca su Internet. Il sistema Gemini di Google, ad esempio, ha un’opzione utente chiamata risposta di doppio controllo, che evidenzierà parti della sua risposta in verde (per mostrare che è stata verificata da una ricerca su Internet) o marrone (per contenuti controversi o incerti). Ciò, tuttavia, è computazionalmente costoso e richiede tempo, afferma Awadallah. E tali sistemi continuano ad avere allucinazioni, dice, perché Internet è pieno di fatti negativi.

Mondo interiore

Un approccio parallelo prevede l’interrogatorio dello stato interiore di un chatbot. Un modo per farlo è far sì che i chatbot parlino da soli, con altri chatbot o con interrogatori umani per sradicare le incoerenze nelle loro risposte. Tale autoriflessione può fermare le allucinazioni. Ad esempio, se un chatbot è costretto a eseguire una serie di passaggi in una “catena di pensiero” – come fa il modello o1 di OpenAI – ciò aumenta l’affidabilità, soprattutto durante le attività che implicano ragionamenti complessi.

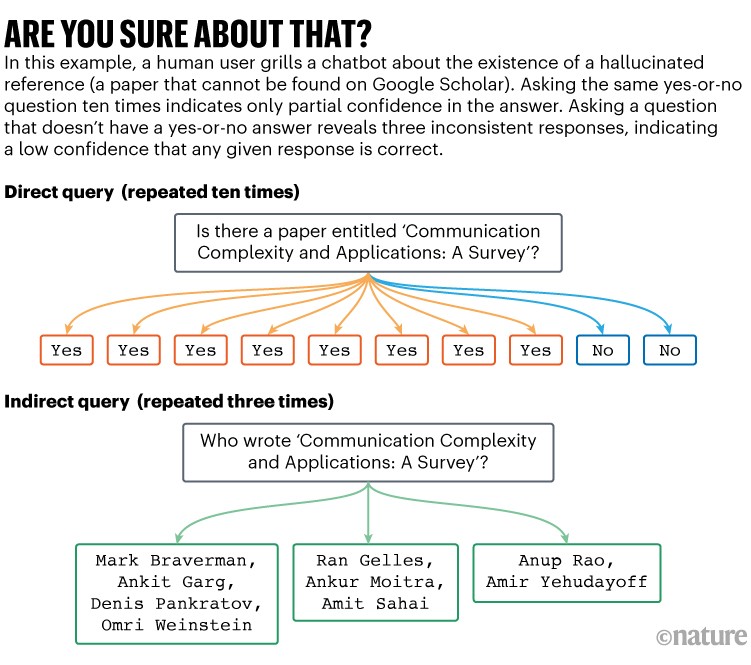

Analizzando i riferimenti alle allucinazioni, Suzgun e i suoi colleghi hanno scoperto che se interrogavano i chatbot utilizzando più domande su un articolo citato, i robot erano meno coerenti nelle loro risposte se avevano allucinazioni (vedi “Sei sicuro di questo?”). La loro strategia era computazionalmente costosa, ma era “abbastanza efficace”, dice Suzgun, anche se non hanno quantificato il miglioramento10.

Fonte: rif. 10

È stato svolto del lavoro per cercare di automatizzare i controlli di coerenza. I ricercatori hanno elaborato modi per valutare la “somiglianza semantica” di una serie di risposte di chatbot alla stessa domanda. Possono quindi mappare la quantità di diversità nelle risposte; molta diversità, o un’elevata “entropia semantica”, è un indicatore di scarsa fiducia11. Controllare quali risposte sono raggruppate insieme in un’area semanticamente densa può anche aiutare a identificare le risposte specifiche che hanno meno probabilità di contenere contenuti allucinati12. Tali schemi non richiedono alcuna formazione aggiuntiva per i chatbot, ma richiedono molti calcoli quando si risponde alle domande.