L’unità di elaborazione grafica H100 del gigante tecnologico NVIDIA è un chip ricercato per la ricerca sull’intelligenza artificiale.Credito: NVIDIA

Secondo un sondaggio condotto tra accademici di decine di istituzioni in tutto il mondo, molti scienziati universitari sono frustrati dalla quantità limitata di potenza di calcolo a loro disposizione per la ricerca sull’intelligenza artificiale (AI).

In che modo i motori di ricerca scientifici basati sull’intelligenza artificiale possono accelerare la tua ricerca

I risultati1pubblicati sul server di prestampa arXiv il 30 ottobre, suggeriscono che gli accademici non hanno accesso ai sistemi informatici più avanzati. Ciò può ostacolare la loro capacità di sviluppare modelli linguistici di grandi dimensioni (LLM) e di svolgere altre ricerche sull’intelligenza artificiale.

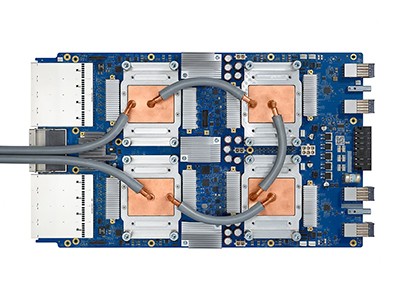

In particolare, i ricercatori accademici a volte non hanno le risorse per ottenere unità di elaborazione grafica (GPU) sufficientemente potenti, chip di computer comunemente utilizzati per addestrare modelli di intelligenza artificiale che possono costare migliaia di dollari. Al contrario, i ricercatori delle grandi aziende tecnologiche hanno budget più elevati e possono spendere di più per le GPU. “Ogni GPU aggiunge più potenza”, afferma il coautore dello studio Apoorv Khandelwal, informatico della Brown University di Providence, Rhode Island. “Mentre questi giganti del settore potrebbero avere migliaia di GPU, gli accademici forse ne hanno solo poche.”

Come i chip per computer all’avanguardia stanno accelerando la rivoluzione dell’intelligenza artificiale

“Il divario tra i modelli accademici e quelli industriali è enorme, ma potrebbe essere molto più ridotto”, afferma Stella Biderman, direttrice esecutiva di EleutherAI, un istituto di ricerca no-profit sull’intelligenza artificiale a Washington DC. La ricerca su questa disparità è “estremamente importante”, afferma.

Lunghe attese

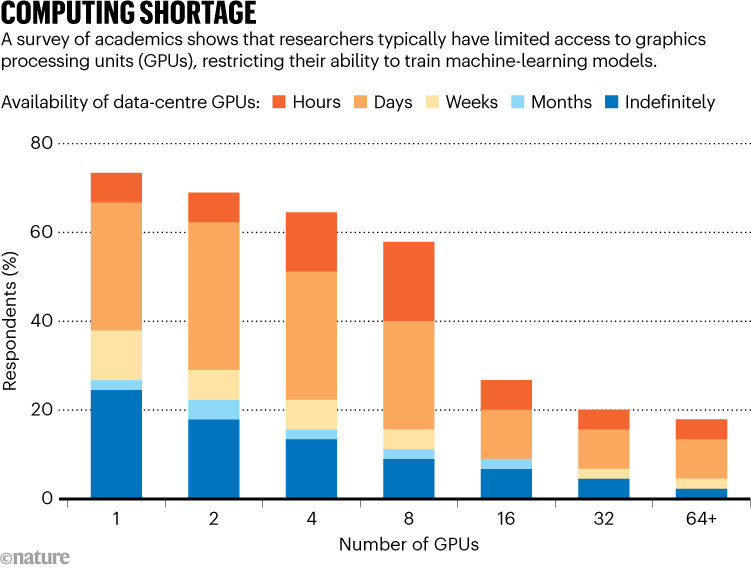

Per valutare le risorse informatiche a disposizione degli accademici, Khandelwal e i suoi colleghi hanno intervistato 50 scienziati in 35 istituzioni. Tra gli intervistati, il 66% ha valutato la propria soddisfazione nei confronti della potenza di calcolo pari a 3 o meno su 5. “Non sono affatto soddisfatti”, afferma Khandelwal.

Le università hanno diverse configurazioni per l’accesso alla GPU. Alcuni potrebbero avere un cluster di elaborazione centrale condiviso da dipartimenti e studenti, dove i ricercatori possono richiedere tempo GPU. Altre istituzioni potrebbero acquistare macchine che i membri del laboratorio possano utilizzare direttamente.

Fonte: rif. 1

Alcuni scienziati hanno affermato di aver dovuto attendere giorni per accedere alle GPU e hanno notato che i tempi di attesa erano particolarmente elevati in prossimità delle scadenze dei progetti (vedere “Carenza di calcolo”). I risultati evidenziano anche le disparità globali nell’accesso. Ad esempio, un intervistato ha menzionato le difficoltà nel reperire GPU in Medio Oriente. Solo il 10% degli intervistati ha affermato di avere accesso alle GPU H100 di NVIDIA, potenti chip progettati per la ricerca sull’intelligenza artificiale.

Questa barriera rende il processo di pre-formazione, ovvero fornire vasti set di dati ai LLM, particolarmente impegnativo. “È così costoso che la maggior parte degli accademici non prende nemmeno in considerazione l’idea di dedicarsi alla scienza durante la pre-formazione”, afferma Khandelwal. Lui e i suoi colleghi pensano che gli accademici forniscano una prospettiva unica nella ricerca sull’intelligenza artificiale e che la mancanza di accesso alla potenza di calcolo potrebbe limitare il campo.

Energia nucleare per l’intelligenza artificiale: cosa servirà per riaprire Three Mile Island in sicurezza

“È davvero importante avere un ambiente di ricerca accademica sano e competitivo per la crescita e lo sviluppo tecnologico a lungo termine”, afferma la coautrice Ellie Pavlick, che studia informatica e linguistica alla Brown University. “Quando si dispone di ricerca di settore, c’è una chiara pressione commerciale e questo incentiva a volte a sfruttare prima e ad esplorare meno.”

Metodi efficienti

I ricercatori hanno anche studiato come gli accademici potrebbero utilizzare meglio le risorse informatiche meno potenti. Hanno calcolato il tempo necessario per pre-addestrare diversi LLM utilizzando hardware con risorse limitate, con un numero di GPU compreso tra 1 e 8. Nonostante queste risorse limitate, i ricercatori sono riusciti ad addestrare con successo molti modelli, anche se ci è voluto più tempo e hanno richiesto l’adozione di metodi più efficienti.

I modelli di intelligenza artificiale alimentati con dati generati dall’intelligenza artificiale emettono rapidamente sciocchezze

“In realtà possiamo semplicemente utilizzare le GPU di cui disponiamo per un periodo più lungo, e così possiamo in un certo senso compensare alcune delle differenze tra ciò che l’industria ha”, afferma Khandelwal.

“È bello vedere che è possibile effettivamente addestrare un modello più grande di quanto molte persone avrebbero ipotizzato con risorse di calcolo limitate”, afferma Ji-Ung Lee, che studia modelli neuroespliciti alla Saarland University di Saarbrücken, in Germania. Aggiunge che il lavoro futuro potrebbe prendere in considerazione le esperienze dei ricercatori del settore nelle piccole aziende, che hanno anche difficoltà ad accedere alle risorse informatiche. “Non è che tutti coloro che hanno accesso a un’elaborazione illimitata lo ottengano”, afferma.